Gracias a la gran variedad de bloques de construcción disponibles en la actualidad para crear experiencias de voz proporcionadas por OpenAI, Google, AWS y Microsoft, la complejidad de crear aplicaciones de asistentes de voz con capacidades conversacionales se ha reducido drásticamente.

Fondo

Si hace cinco años un cliente nos hubiera pedido una aplicación móvil en la que los usuarios pudieran hacer preguntas con su voz y la aplicación respondiera de forma natural, con una voz amigable y extrayendo información de una base de conocimientos específica relacionada con el ámbito del cliente (por ejemplo, una cadena de supermercados cuyos clientes pudieran hacer a la aplicación preguntas como "¿En qué tienda puedo encontrar huevos ecológicos?"), yo habría presupuestado un proyecto enorme, habría pedido ayuda a muchos de nuestros socios y habría calificado el proyecto de muy arriesgado.

Sin embargo, desde que OpenAI liberó sus modelos para el consumo de terceros a través de API, ha permitido a todo el mundo integrar la IA Generativa en sus negocios. Más tarde, otros actores importantes del mercado lanzaron sus modelos conversacionales y añadieron soporte de voz, como Vertex AI de Google y AWS Lex.

Caso práctico

Hace poco tuvimos la oportunidad de utilizar la API en tiempo real de OpenAI para ofrecer una aplicación a un cliente cuya base de conocimientos era difícil de entender, buscar y aprender para muchas personas.

El objetivo: crear una aplicación móvil que ayude a los usuarios a navegar por la base de conocimientos y les permita utilizar su voz para consultarla.

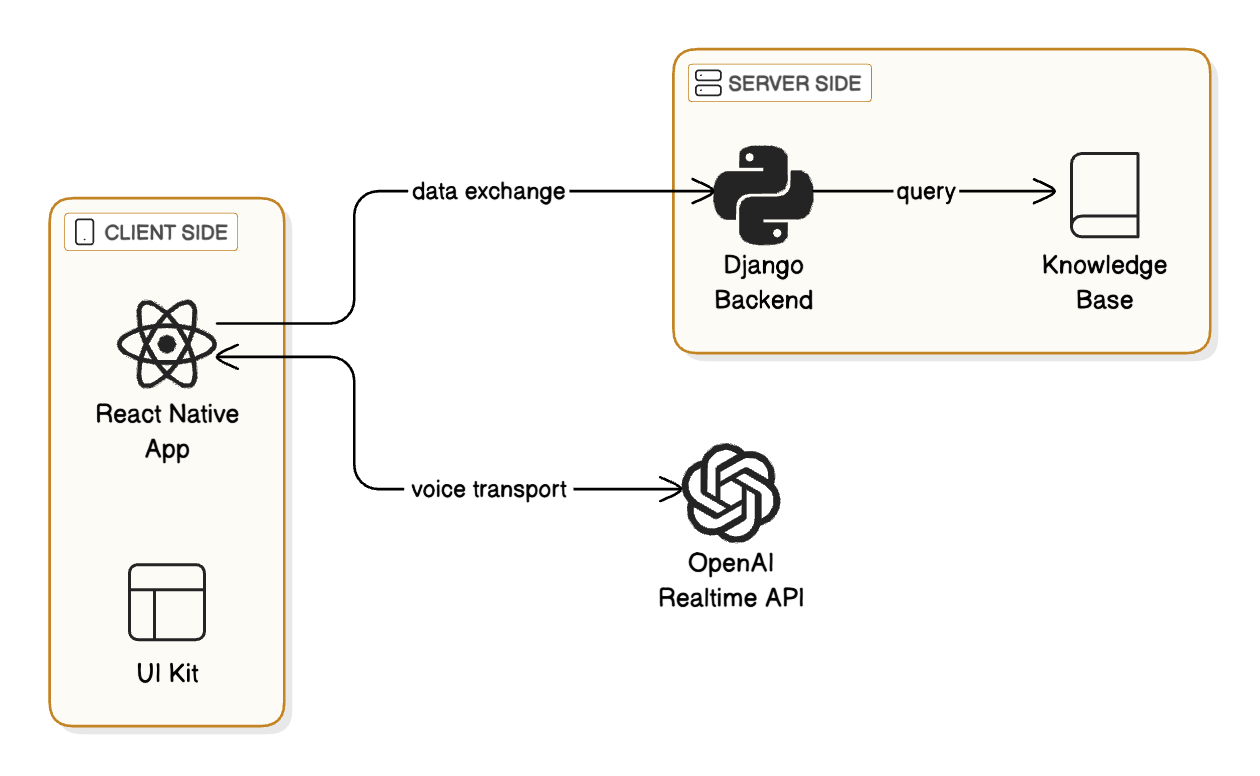

El presupuesto era limitado, por lo que solo podíamos asignar un pequeño equipo de dos personas -un desarrollador backend y un desarrollador móvil- durante unas semanas. Elegimos React Native para construir la aplicación, ya que necesitábamos salir al mercado rápidamente, y este cliente no requería una experiencia de grado nativo. Además, utilizamos un UI Kit para el desarrollo UX/UI, WebRTC para el transporte de voz y un backend Django para conectar la aplicación a la base de conocimientos.

Inteligencia artificial generativa

Antes de elegir qué proveedor de IA utilizar, hicimos una comparación entre funciones y costes, y la API en tiempo real de OpenAI fue la ganadora (el coste es de unos 0,40 dólares por cada cinco minutos de audio para GPT4o-mini).

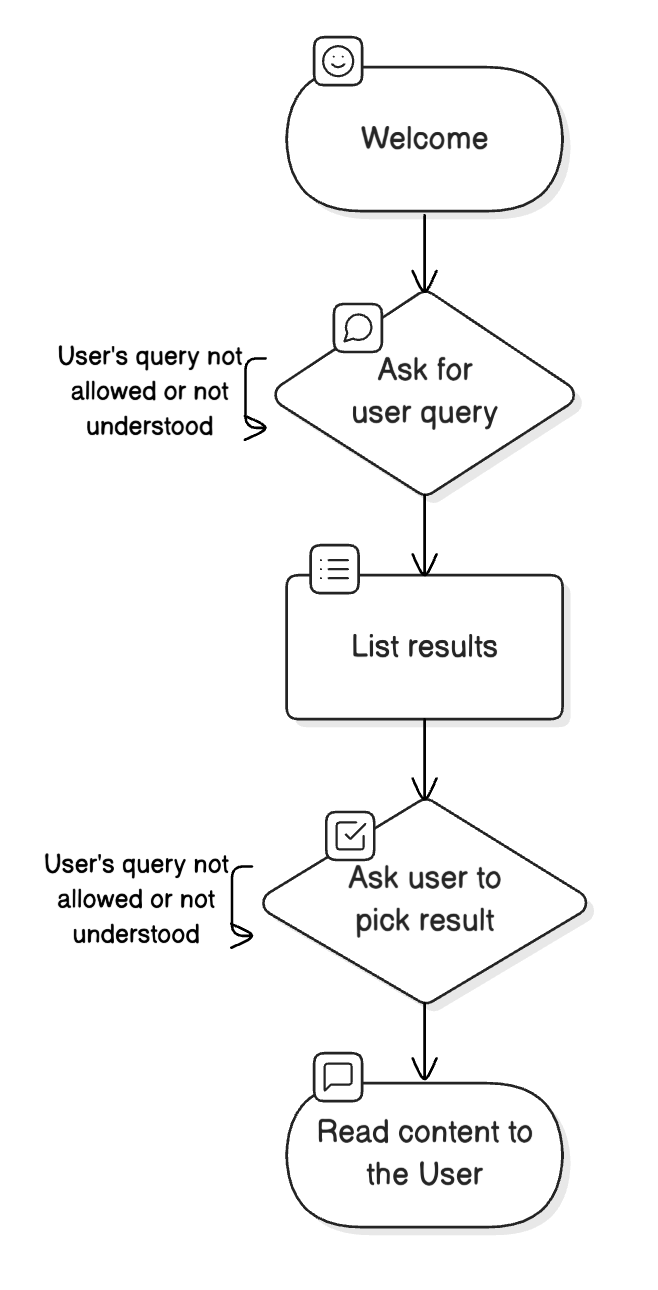

Aprovechamos sus funciones de agente para crear un agente que guiara a los usuarios a través de las conversaciones hasta que llegaran al contenido deseado.

El trabajo duro del proyecto incluyó el diseño de la interfaz de usuario de la aplicación, la creación de la capa API para acceder a la base de conocimientos y la ingeniería para crear el agente, que aprovechó la función de "funciones" para extraer datos de fuentes externas.

Al redactar la pregunta, tuvimos que asegurarnos de que el agente no se desviara de las respuestas generadas por la base de conocimientos, pero también de que fuera lo suficientemente flexible como para permitir al usuario buscar utilizando una docena de estilos de preguntas diferentes.

Conectar el agente a la base de conocimientos aws también un reto, ya que teníamos que asegurarnos de que las frases en lenguaje natural que el usuario utilizaba para buscar temas se convirtieran en consultas estructuradas que pudiéramos enviar a una base de datos.

El uso de los módulos de Open AI hizo posible este proyecto, reduciendo la complejidad a "sólo" tener que crear una aplicación móvil normal. Tras unas semanas y demostraciones al cliente, la aplicación estaba lista.

En Nimble Gravity ofrecemos soluciones rentables para validar productos rápidamente. Póngase en contacto con nosotros si cree que podemos ayudarle con retos similares.

.jpg)