La inteligencia artificial está transformando rápidamente la forma en que las organizaciones operan, toman decisiones y ofrecen valor a los clientes. Desde los servicios financieros que aprueban préstamos hasta los proveedores sanitarios que recomiendan tratamientos, los sistemas de IA influyen cada vez más en los resultados que afectan a la vida de las personas. Sin embargo, la adopción no es sólo una cuestión de capacidad técnica. La confianza sigue siendo el factor determinante. Para que las empresas confíen en la IA en la toma de decisiones críticas, deben asegurarse de que los sistemas sean transparentes y comprensibles. Aquí es donde la capacidad de explicación es fundamental.

La explicabilidad es más que un requisito de cumplimiento. Es la base de la arquitectura de confianza que las organizaciones deben construir para aprovechar plenamente la IA al tiempo que protegen a las partes interesadas y su reputación.

Por qué es importante la explicabilidad

Los sistemas tradicionales de análisis e inteligencia empresarial han proporcionado durante mucho tiempo una lógica clara y trazable. Los responsables de la toma de decisiones podían ver las entradas y entender el razonamiento. Los modelos de IA, en particular los sistemas de aprendizaje profundo, suelen funcionar como cajas negras. Ofrecen predicciones muy precisas, pero con poca visibilidad sobre cómo se forman esas predicciones.

Para ejecutivos, reguladores y clientes, esta opacidad plantea preocupaciones legítimas:

- Responsabilidad: Si un modelo comete un error, ¿quién es el responsable y cómo puede corregirse?

- Equidad: ¿Los modelos introducen o amplifican prejuicios que perjudican a determinados grupos?

- Cumplimiento de la normativa: Muchos sectores se enfrentan a requisitos legales para explicar las decisiones automatizadas, especialmente en finanzas, sanidad y seguros.

- Confianza: Es menos probable que los clientes adopten o acepten resultados que no pueden entender.

Sin capacidad de explicación, incluso el sistema de IA más preciso corre el riesgo de ser rechazado. La confianza se genera cuando las partes interesadas conocen no solo el "qué", sino también el "por qué" de cada decisión.

Principios básicos de la IA explicable

Incorporar la explicabilidad a los sistemas de IA requiere algo más que añadir informes a posteriori. Implica principios de diseño que den prioridad a la claridad y la transparencia desde el principio. Los enfoques más eficaces reflejan estos principios:

- Transparencia

Los modelos deben proporcionar visibilidad de su estructura, fuentes de datos y procesos de razonamiento. Esto no significa exponer algoritmos patentados, sino ofrecer descripciones claras de cómo se generan los resultados.

- Interpretabilidad

Las explicaciones deben ser comprensibles para el público al que van dirigidas. Un científico de datos técnicos puede necesitar atribuciones detalladas de las características, mientras que un ejecutivo de negocios puede necesitar sólo un resumen de alto nivel.

- Coherencia

Las explicaciones no deben variar de forma imprevisible. Unas salidas coherentes generan confianza en el usuario de que el sistema se comporta de forma fiable.

- Accionabilidad

Las partes interesadas deben poder utilizar las explicaciones para tomar mejores decisiones. Por ejemplo, un funcionario bancario debe entender por qué se ha marcado una solicitud de préstamo para poder tomar medidas correctivas si es necesario.

Al adherirse a estos principios, las organizaciones diseñan sistemas de IA que son a la vez potentes y fiables.

Herramientas y técnicas de explicabilidad

Han surgido varias herramientas y métodos para hacer más transparente la IA. Cada uno ofrece diferentes puntos fuertes en función de la complejidad del modelo y las necesidades de las partes interesadas:

- Los métodos de atribución de características, como SHAP o LIME, ponen de relieve qué variables influyeron más en una predicción.

- Las técnicas de simplificación de modelos destilan modelos complejos en formas más interpretables sin sacrificar demasiada precisión.

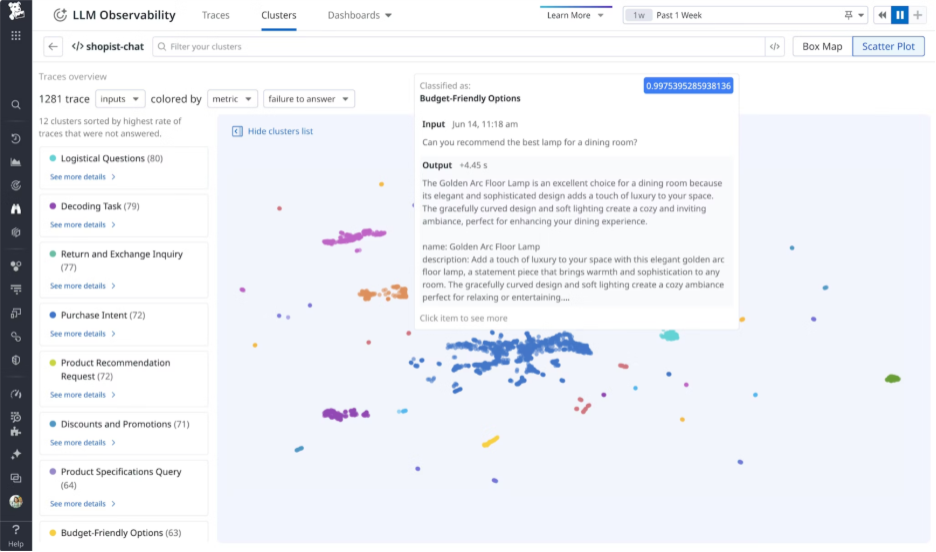

- Las herramientas de visualización traducen el comportamiento abstracto del modelo en tablas o gráficos intuitivos. Un buen ejemplo es el módulo LLM Observability de Datadog.

- Las superposiciones basadas en reglas combinan la lógica if-then tradicional con los resultados de la IA para que los procesos de decisión sean más claros.

Mediante una combinación de estos enfoques, las empresas pueden adaptar las explicaciones a distintos públicos sin perder rigor.

Impacto empresarial de la IA explicable

La explicabilidad no sólo satisface a los reguladores. Genera beneficios empresariales tangibles:

- Mejora de la toma de decisiones: Una visión más clara permite a los líderes actuar con mayor confianza.

- Reducción de riesgos: Los sistemas transparentes facilitan la detección y corrección de errores antes de que causen daños.

- Confianza y fidelidad del cliente: Las empresas que pueden explicar los resultados establecen relaciones más sólidas con los clientes, que se sienten tratados con justicia.

- Preparación para la innovación: Las organizaciones que priorizan la explicabilidad están mejor posicionadas para experimentar con nuevas aplicaciones de IA sin temor a consecuencias incontroladas.

En resumen, la explicabilidad hace que la IA deje de ser una arriesgada caja negra y se convierta en un socio fiable para el crecimiento empresarial.

Crear una cultura de IA transparente

La explicabilidad no es sólo un problema técnico. También es cultural. Las empresas deben crear entornos en los que la claridad y la responsabilidad se valoren tanto como las métricas de rendimiento. Esto significa:

- Formar a los empleados para que comprendan los conceptos de IA a nivel práctico.

- Establecer estructuras de gobernanza que exijan explicaciones de todas las decisiones automatizadas.

- Recompensar a los equipos no sólo por la precisión, sino también por la claridad de sus modelos.

Al integrar la transparencia en la cultura, las organizaciones refuerzan la confianza que la tecnología por sí sola no puede garantizar.

La confianza como activo estratégico

La confianza no es un subproducto de la adopción de la IA; es el resultado de un diseño y una gobernanza deliberados. Las organizaciones que dan prioridad a la explicabilidad crean sistemas que inspiran confianza, reducen el riesgo y permiten la innovación a largo plazo. A medida que la IA se entreteja más profundamente en las decisiones empresariales, quienes construyan la arquitectura de la confianza destacarán.

En un mercado en el que la tecnología está al alcance de muchos, la confianza se convierte en el verdadero factor diferenciador. Las empresas que integran la explicabilidad en todas las fases no sólo cumplen los requisitos de conformidad, sino que también se ganan la confianza de clientes, socios y reguladores. La confianza, una vez establecida, se convierte en un activo estratégico que acelera el crecimiento y garantiza que las decisiones impulsadas por la IA conduzcan a un éxito sostenible.